En el último año se ha registrado un incremento del 890 % del uso de las aplicaciones de IA generativa, según se recoge en el informe de Palo Alto “2025 State of GenAI Report”, que analiza el estado de la implantación de la inteligencia artificial generativa en las empresas a partir del análisis del tráfico de más de 7.000 organizaciones globales durante 2024 y el primer trimestre de 2025.

Este auge no está exento de riesgos ya que como revela el informe en el primer trimestre de 2025, los incidentes de pérdida de datos (DLP) vinculados a la IA generativa se multiplicaron por 2,5, lo que supone que 14 % de los incidentes registrados.

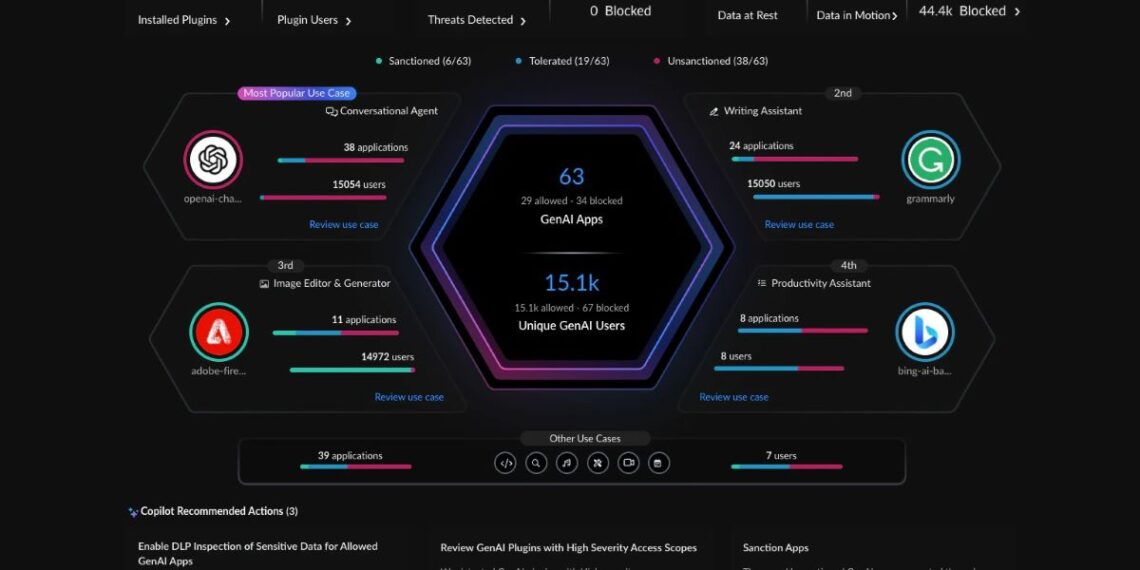

A la vez, Palo Alto ha comprobado que el número medio de aplicaciones de IA generativa detectadas por organización asciende a 66 y que uno de los aspectos más preocupantes es que no hay control en muchos casos, apareciendo el fenómeno Shadow AI, que es el uso no autorizado de herramientas de IA por parte de empleados sin supervisión del área de TI.

Esta práctica erosiona la visibilidad y complica el cumplimiento normativo. Y, como revela el informa, las organizaciones conviven con una media de 6,6 aplicaciones de IA generativa de alto riesgo sin un marco de control claro.

El análisis indica que el 83,8 % de las interacciones con IA generativa analizadas proceden de plataformas de asistencia a la escritura, agentes conversacionales, buscadores corporativos y entornos de desarrollo.

El asistente de escritura más utilizado, con un 39 % del tráfico, es Grammarly y las aplicaciones de Microsoft Copilot o Copilot Studio, con casi el 49 %, son las más usadas en el terreno de los agentes de IA. En nuestro país, el informe destaca que las tres herramientas de IA generativa más usadas por volumen son Microsoft 365 Copilot (24,1 %), Microsoft PowerApps (23,9 %) y ChatGPT de OpenAI (23,4 %).

En este contexto, el informe señala que más del 70 % de las aplicaciones evaluadas fueron susceptibles a ataques de tipo jailbreak, capaces de inducir respuestas con contenido autolesivo, discriminatorio, ofensivo o instrucciones sobre actividades ilegales.

Ante esta situación, Palo Alto recomienda controlar el uso de la IA generativa y definir qué se puede permitir, proteger los datos sensibles y defenderse frente a ciberamenazas modernas basadas en la IA.